Im März 2017 stürzte die Rescue 116 auf ein 282 Fuß hohes Hindernis – die Blackrock Island vor der Küste der Grafschaft Mayo. Weitere Untersuchungen ergaben, dass der Hubschrauberbetreiber CHC Ireland nicht über ein „formalisiertes, standardisiertes, kontrolliertes oder regelmäßiges“ System verfügte. Aus diesem Grund fehlten in der Datenbank, die der Betreiber zur Überprüfung der Flugrouten verwendet, Angaben zur Blackrock-Insel. Berichten zufolge wurde die Besatzung erst 13 Sekunden vor dem Hindernis auf ihrer Flugroute gewarnt. Das Schlimmste daran ist, dass vier Jahre vor dem Vorfall eine Beschwerde über diese Ungenauigkeit in der Datenbank der irischen Küstenwache eingereicht wurde, aber keine Abhilfemaßnahmen getroffen wurden.

In einer Welt, in der jede Handlung datengesteuert ist (ob diese Tatsache nun offiziell anerkannt wird oder nicht), beweisen solche Vorfälle, dass die Kosten einer schlechten Datenqualität stark unterschätzt werden. Die größte Herausforderung bei der Bewertung der Datenqualität besteht jedoch darin, dass es keine schnellen und zeitnahen Maßnahmen gibt, die die Beteiligten warnen können, wenn die Qualität ihrer Daten unter einen akzeptablen Wert fällt.

Zehn Dimensionen der Bewertung der Datenqualität

Einfach ausgedrückt: Datenqualität ist dann gewährleistet, wenn die Daten für den beabsichtigten Zweck verwendet werden können, ohne dass dabei Fehler auftreten. Die Datenqualität wird in der Regel anhand dieser zehn kritischen Dimensionen gemessen:

Es stellt sich jedoch häufig die Frage, wie schnell diese Dimensionen gemessen werden können – und auf welchem Niveau -, so dass die Teams rechtzeitig vor einer Verschlechterung der Datenqualität und deren Auswirkungen auf die Datenbetriebskosten gewarnt werden können.

Messung am Freitagnachmittag (FAM) – Schnelle Bewertung der Datenqualität

Tom Redman schlug die Friday Afternoon Measurement-Methode (FAM) vor, mit der die Frage schnell und wirkungsvoll beantwortet werden kann: Muss ich mir Sorgen um die Datenqualität machen?

Diese Methode bietet eine schnelle und effektive Berechnungsmethode, die an einem Freitagnachmittag, wenn der Arbeitsrhythmus sich verlangsamt hat, in etwa einer Stunde erledigt werden kann – daher auch der Name. Mit dieser Methode kann die Datenqualität wöchentlich bewertet werden, so dass rote Fahnen gesetzt werden können, bevor die Situation außer Kontrolle gerät. Nach Ansicht der FAM kann die Datenqualität wie folgt gemessen werden:

Schritt 1: Zusammenstellung aktueller Daten

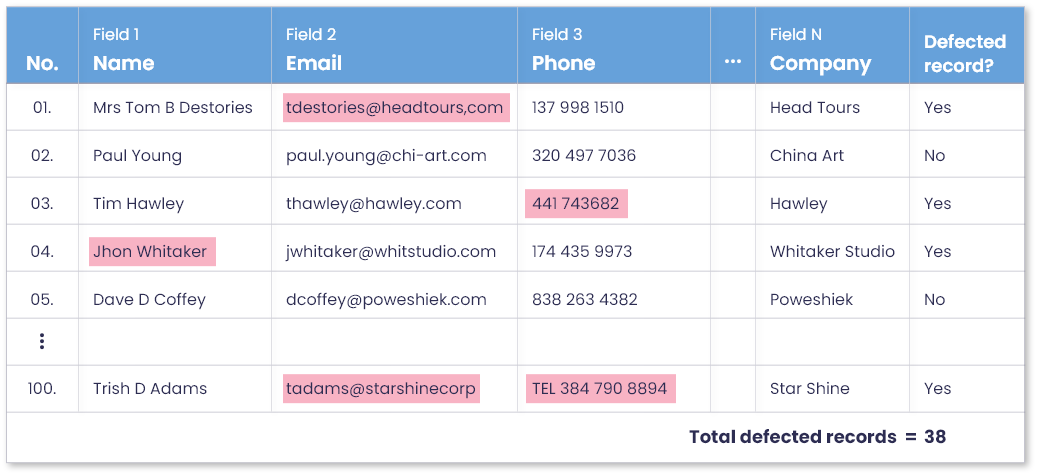

Beginnen Sie mit der Sammlung von Beispieldaten aus den jüngsten datenbezogenen Aktivitäten in Ihrer Abteilung. Für die Vertriebsabteilung können dies zum Beispiel die letzten 100 Datensätze in Ihrem CRM sein. Hier können Sie entweder die zuletzt erstellten oder die zuletzt verwendeten Daten verwenden. Sobald Sie diese 100 Datensätze haben, wählen Sie 10-15 Datenelemente oder Attribute aus – im Grunde die wichtigsten Informationen über diese Datensätze.

Schritt 2: Kennzeichnung von fehlerhaften und fehlerfreien Datensätzen

Laden Sie einige Personen aus Ihrem Team ein, die sich mit den betreffenden Daten auskennen, und bitten Sie sie, an einem zweistündigen Treffen mit Ihnen teilzunehmen. Gehen Sie die ausgewählten Datensätze und ihre Attribute durch und markieren Sie alle Werte, bei denen Sie einen Datenqualitätsfehler feststellen (d. h. der Wert ist null, ungültig, falsch geschrieben usw.).

Dieser Vorgang dauert in der Regel nicht sehr lange, da Fehler in der Datenqualität meist offensichtlich sind. Es könnte jedoch eine kleine Anzahl von Datensätzen geben, die tiefere Diskussionen zwischen den Teammitgliedern erfordern, um Probleme mit der Datenqualität zu analysieren.

Wenn Sie diese Unstimmigkeiten in allen Datensätzen markiert haben, können Sie nun eine neue Spalte mit der Bezeichnung „Perfekter Datensatz“ in den Beispieldatensatz einfügen und die Spaltenwerte je nachdem, ob bei einem Datensatz ein Fehler aufgetreten ist oder nicht, ausfüllen. Am Ende können Sie die Anzahl der im Musterdatensatz markierten fehlerhaften und fehlerfreien Datensätze addieren und berechnen.

Schritt 3: Messung der Datenqualität in Prozent

Jetzt ist es an der Zeit, die Dinge ins rechte Licht zu rücken und schlüssige Ergebnisse zu erzielen. Angenommen, von den letzten 100 Datensätzen, die Ihr Team erstellt oder verwendet hat, erwiesen sich nur 62 als vollkommen perfekt, während die restlichen 38 einen oder mehrere Datenqualitätsfehler aufwiesen. Eine Fehlerquote von 38 % in einem kürzlich erhobenen/verwendeten Datensatz lässt die Alarmglocken schrillen und bestätigt, dass Ihre Abteilung ein Problem mit der Datenqualität hat.

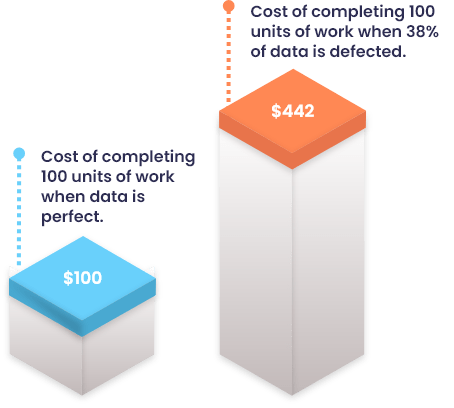

Schritt 4: Anwendung der Zehnerregel (RoT) zur Berechnung der Kosten einer schlechten Datenqualität

Die Methode ist hier noch nicht zu Ende. Darüber hinaus werden die geschätzten Kosten einer schlechten Datenqualität berechnet, so dass Ihr Team – und die Führungskräfte – die Auswirkungen schlechter Daten verstehen können. Bei dieser Kostenberechnung wird die Zehnerregel berücksichtigt: Es kostet zehnmal mehr, eine Arbeitseinheit abzuschließen, wenn die Daten fehlerhaft sind, als wenn sie perfekt sind.

Wenn zum Beispiel die Kosten für eine einzige Arbeitseinheit bei perfekten Daten 1 $ betragen, können die Gesamtkosten wie folgt berechnet werden:

Gesamtkosten = (62$1) + (38$1*10) = $62 + $380 = $442

Dies zeigt, dass fehlerhafte Datensätze etwa viermal so teuer sind, wie wenn die Daten perfekt wären. Da Sie nun wissen, dass Sie ein Datenqualitätsproblem haben und die Kosten für dessen Auswirkungen kennen, können Sie nun Korrekturmaßnahmen ergreifen, um diese Fehler zu beheben.

Implementierung von FAM mit DataMatch Enterprise – die beste Datenqualitätssoftware ihrer Klasse

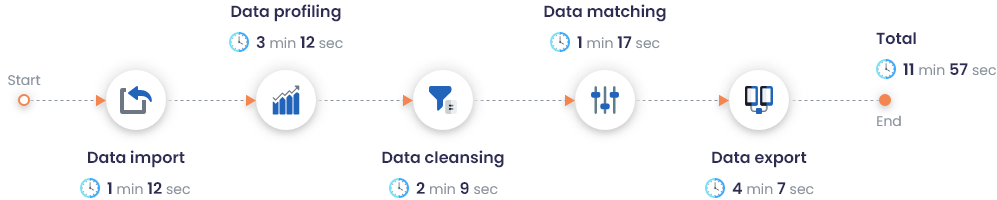

Die FAM-Methode hat sich als sehr kosten- und zeiteffiziente Methode erwiesen, da sie in einer zweistündigen Sitzung zwischen zwei bis drei Teammitgliedern Ergebnisse liefert. Diese Zeit kann jedoch auf nur 3-5 Minuten reduziert werden, wobei nur ein einziges Teammitglied involviert ist – durch den Einsatz eines Self-Service-Softwaretools für Datenqualität.

DataMatch Enterprise (DME) ist ein komplettes Tool für das Datenqualitätsmanagement, das eine Vielzahl von statistischen Algorithmen für die Profilerstellung, die Bereinigung, den Abgleich und die Deduplizierung Ihrer Daten einsetzt. Es verfügt über umfangreiche Profiling-Funktionen, die einen sofortigen 360°-Bericht über Ihre Datenqualität erstellen, indem leere Werte, falsche Formate und Datentypen, ungültige Muster und andere beschreibende Statistiken identifiziert werden.

Automatische Kennzeichnung von perfekten und unperfekten Unterlagen in Sekundenschnelle

Anstatt Diskrepanzen in Ihrem Datensatz manuell zu identifizieren und zu markieren, kann Ihr Team mit DME im Alleingang einen Bericht erstellen, der perfekte und unperfekte Datensätze in nur wenigen Sekunden kennzeichnet und nummeriert – selbst bei einer Stichprobengröße von 2 Millionen Datensätzen.

Die Leistung von DataMatch Enterprise bei einem Datensatz mit 2 Millionen Datensätzen wurde wie folgt aufgezeichnet:

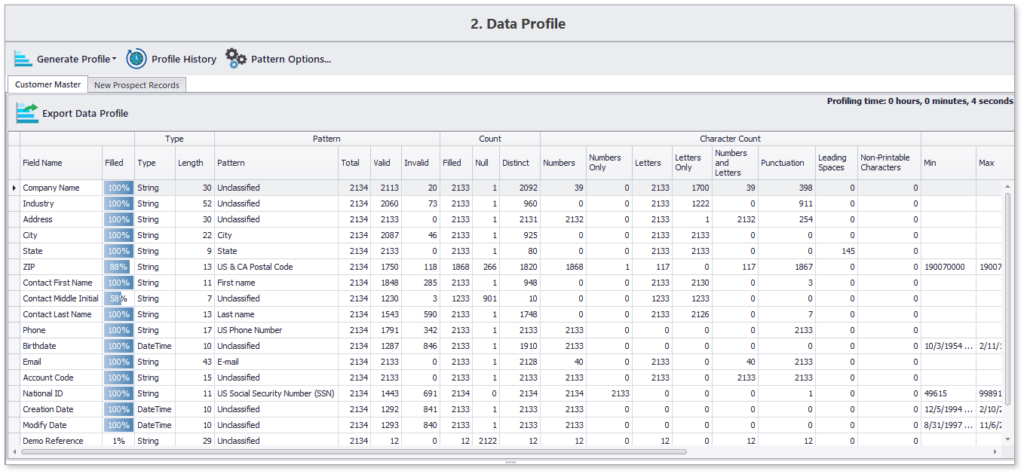

Detaillierte Erstellung und Filterung von Datenqualitätsprofilen

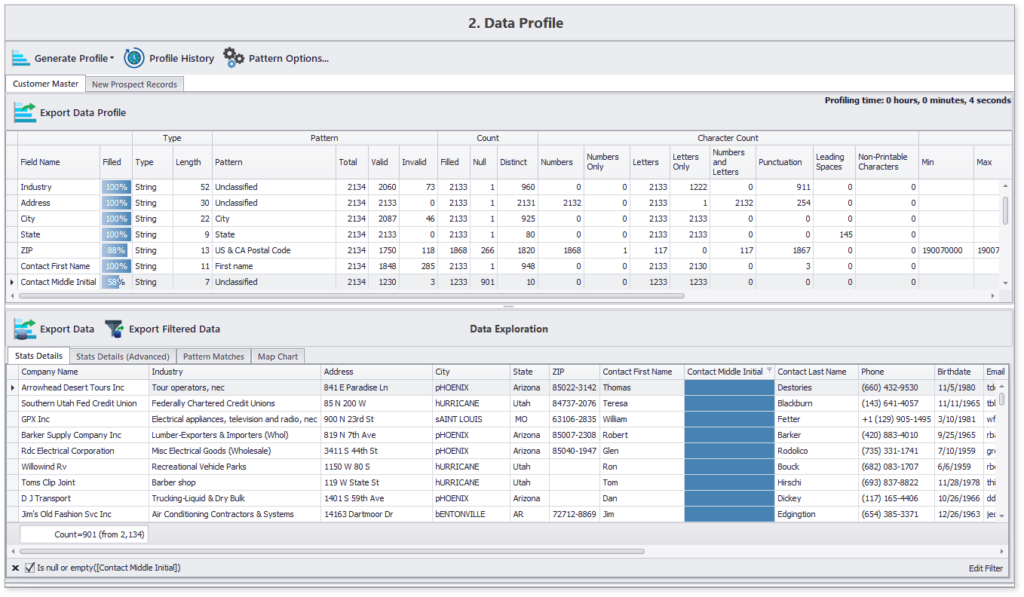

Hier ist ein Beispielprofil, das mit DME in weniger als 10 Sekunden für etwa 2000 Datensätze erstellt wurde:

Dieses prägnante Datenprofil hebt den Inhalt und die Strukturdetails aller ausgewählten Datenattribute hervor. Darüber hinaus können Sie auch zu Besonderheiten navigieren, z. B. zur Liste der 12 % Datensätze, in denen der zweite Vorname des Kontakts fehlt.

Was kommt als Nächstes – Von der Datenqualitätsbewertung zur Datenqualitätsbehebung

Die Funktionen und Möglichkeiten von DME enden nicht mit der Bewertung der Datenqualität, sondern sind darauf ausgelegt, die Bewertungsergebnisse zur Behebung von Datenqualitätsproblemen zu nutzen:

- Durchführung verschiedener Datenbereinigungs- und Standardisierungstechniken zur Korrektur unvollständiger, ungültiger oder falsch formatierter Werte.

- Ausführen von Datenabgleichsalgorithmen, die Duplikate mit exakten und unscharfen Abgleichstechniken identifizieren.

- Konfigurieren von Regeln zur Auswahl eindeutiger Datensätze in der Gruppe der identifizierten Duplikate.

- Überschreiben von Spaltenwerten, um eine einzige Quelle der Wahrheit zu erhalten

Darüber hinaus lässt sich DME mit praktisch jeder Quelle integrieren und zieht Datensätze, die bis zum angegebenen Datum zurückreichen, sowie saubere und standardisierte Ergebnisse an die Quelle zurück. All diese Funktionen sind in einer Software für Datenqualität aus einer Hand vereint, die für den Einsatz in jeder Abteilung jeder Branche konzipiert ist.

Wenn Sie mehr darüber erfahren möchten, wie unsere Lösung Sie bei der Implementierung der FAM-Methode für Ihren Datensatz unterstützen oder Ihre Datenqualitätsprobleme lösen kann, melden Sie sich noch heute für eine kostenlose Testversion an oder vereinbaren Sie eine Demo mit einem unserer erfahrenen Experten.