In einer Welt, die von den grenzenlosen Möglichkeiten von KI, ML und prädiktiver Analyse fasziniert ist, ist die Datenqualität zu einer großen Herausforderung geworden. Unternehmen sind in einer Zwickmühle: Sie brauchen genaue Daten, um maßgeschneiderte Erlebnisse zu schaffen, aber sie haben nicht die Kapazitäten, um mit schlechten Daten umzugehen.

Unternehmen müssen sich mit zwei lähmenden Aspekten der Datenqualität auseinandersetzen: schmutzige Daten (doppelte Daten, Rechtschreibfehler, unvollständige Informationen usw.) und nicht konforme Daten. Dazu gehören Daten, die Unternehmen dem Risiko von GDPR-Verstößen aussetzen, ungenaue Analysen und fehlerhafte Berichte.

In diesem Beitrag werden wir uns auf Folgendes konzentrieren:

- Verstehen der kritischen Herausforderungen bei der Datenqualität

- Die wichtigsten Herausforderungen für die Datenqualität, mit denen sich Unternehmen schwer tun

- Die 3Ds anhand einer Fallstudie verstehen

- Wie Data Ladder hilft, diese Herausforderungen zu meistern

Lassen Sie uns eintauchen.

Die wichtigsten Herausforderungen für die Datenqualität, die Unternehmen schwer zu bewältigen haben

Experten verwenden gerne den Begriff „Garbage in, garbage out“, um das Problem der Datenqualität zu definieren – aber es steckt mehr dahinter.

Eine Erkenntnis aus dem OReilly-Bericht über den Stand der Datenqualität lautet:

„Unternehmen haben mit mehreren, gleichzeitigen Datenqualitätsproblemen zu kämpfen. Sie haben zu viele verschiedene Datenquellen und zu viele inkonsistente Daten. Sie haben nicht die Ressourcen, die sie benötigen, um Datenqualitätsprobleme zu bereinigen. Und das ist nur der Anfang.“

Die gute Nachricht? Die Führungskräfte in den Unternehmen sind sich dieser großen Herausforderung bewusst.

Die schlechte Nachricht? Ihnen fehlen die Instrumente, Ressourcen und Lösungen, um dieses Problem zu lösen. Viele haben noch immer Probleme mit grundlegenden Datenverwaltungsprozessen.

In unserer Erfahrung mit mehr als 4.500 Kunden, darunter Behörden und Fortune-500-Unternehmen, stellen wir häufig drei gemeinsame Probleme fest:

- Daten, die in mehreren Quellen oder disparaten Systemen gespeichert sind

- Daten, die die Qualitätsziele nicht erfüllen

- Das Fehlen einer robusten Lösung für den Datenabgleich, die tief verborgene Duplikate aussondern kann

Unternehmen brauchen dringend Hilfe beim Umgang mit uneinheitlichen, verschmutzten und doppelten Daten.

Die 3Ds der Daten verstehen

Verschmutzte, uneinheitliche und doppelte Daten wirken sich auf Unternehmen auf einer tieferen Ebene aus. Sie beeinflussen die organisatorischen Abläufe und die betriebliche Effizienz. Sie behindern die Bemühungen um den Aufbau einer datengesteuerten Kultur und sind die Hauptursache für fehlerhafte Analysen und Berichte.

Ungleiche Daten:

Im Durchschnitt ist ein Unternehmen mit über 461 Anwendungen oder Systemen verbunden. Diese Systeme sammeln Daten in verschiedenen Formaten, die dann in einen Data Lake eingespeist werden. Unternehmen, die nicht über Data Lakes verfügen, versuchen, diese Daten ihren ERP-Systemen hinzuzufügen, aber die Herausforderungen bei der Datenformatierung und -zuordnung machen dies zu einem langwierigen Prozess. Dies hat zur Folge, dass die Daten erst dann sortiert oder bearbeitet werden, wenn ein dringender Bedarf besteht.

Nehmen wir zum Beispiel den Fall der Bell Bank – einer renommierten Bank mit einem Dienstleistungsangebot, das sich über alle 50 US-Bundesstaaten erstreckt. Als Teil ihres Kernwerts, personalisierte Kundenerlebnisse zu bieten, wollte die Bank ihre Kunden besser verstehen, indem sie ihre Beziehung und Interaktion an verschiedenen Berührungspunkten auswertete. Zu diesem Zweck mussten sie für jeden ihrer Kunden eine einzige Version der Wahrheit erstellen. Dazu musste das Unternehmen Millionen von Datenreihen bereinigen, abgleichen und bereinigen, um schließlich ein konsolidiertes Bild der Kundenreise zu erhalten.

Aber was genau sind disparate Datenquellen? Handelt es sich nur um Daten, die in verschiedenen Quellen gespeichert sind?

Nun, nein.

Unterschiedliche Daten werden nicht nur in verschiedenen Quellen gespeichert, sondern haben auch unterschiedliche Datenformate, verschiedene Standards und gelten in der Regel als minderwertige Daten. Die Daten unterscheiden sich deutlich in Art, Qualität oder Charakter.

Die Bell Bank muss Daten aus dem Marketing, dem Vertrieb, dem Kundensupport und von Drittanbietern ableiten, um ein klares Bild vom Profil eines Kunden, seiner Interaktion mit dem Unternehmen, seinen Haushaltsdaten und vielem mehr zu erhalten. All diese „disparaten“ Daten müssen durch einen Datenabgleich konsolidiert werden, der der Bank schließlich ihre dringend benötigte Version der Wahrheit liefert.

Die Bell Bank ist nur ein Beispiel für viele Unternehmen, Banken, Einzelhändler und Institutionen, die erkannt haben, wie wichtig es ist, eine einzigartige Kundensicht zu erhalten. In einer Zeit, in der Kunden personalisierte Erlebnisse verlangen, noch bevor sie danach fragen, hilft eine konsolidierte Ansicht Unternehmen, einen Schritt voraus zu sein. Da die Bell Bank die Reise ihrer Kunden versteht, kann sie personalisierte Dienstleistungen wie spezielle Kundenkarten, Rabatte, Mitgliedschaftsvorteile usw. anbieten. Unzusammenhängende Daten hindern Unternehmen daran, diesen tieferen Einblick zu gewinnen, und machen es ihnen somit unmöglich, irgendeinen Wert aus ihren Daten zu schöpfen.

Schmutzige Daten

Behalten Sie alle oben genannten Probleme mit unterschiedlichen Datenquellen bei und fügen Sie weitere hinzu, z. B:

- Falsche Schreibweisen

- Unvollständige Informationen (Adressdaten ohne Postleitzahlen, fehlende Ziffern in Telefonnummern usw.)

- Verwendung von Interpunktion in Datenfeldern

- Negative Abstände

- Probleme bei der Formatierung

Man sollte meinen, dass dies mit Filtern und Autokorrekturen leicht zu bewerkstelligen ist. Aber es gibt Unternehmen, die nichts anderes tun, als physische Straßenadressen in Datenbanken zu bereinigen – weil die Leute unterschiedliche Begriffe für die Straße verwenden. (z. B. Straße, St., ST). Ihre Datenanalysten und -spezialisten müssen über 80 % ihrer Zeit mit der Korrektur dieser Rohdaten verbringen – Zeit und Talent, die eigentlich für die Analyse und nicht für die Korrektur von Schreibweisen oder Abkürzungen vorgesehen waren.

Leider sind die über Websites und Callcenter erhobenen Daten oft fehlerhaft. Daten aus sozialen Medien sind ebenfalls problematisch, was ihre Gültigkeit und Genauigkeit angeht. Daten, die durch menschliche Eingaben erhoben werden, sind fast nie sauber. Aber einen Datenanalysten zu beauftragen, sich durch Millionen von Datenreihen zu arbeiten und die Datenkorrektur zu einem festen Bestandteil seiner Arbeit zu machen, ist keine Lösung.

Die Datenbereinigung ist eine ständige Notwendigkeit. Das bedeutet, dass Ihr Unternehmen eine automatisierte Lösung benötigt, die von einem Datenanalysten oder einem Geschäftsanwender überwacht und bedient wird, damit dieser die nötige Zeit hat, sich auf die Gewinnung von Erkenntnissen zu konzentrieren.

Duplizierte Daten

Doppelte Daten entstehen, wenn dieselben Informationen in verschiedenen Datenquellen in unterschiedlichen Formaten gesammelt und gespeichert werden. Und dies geschieht in erschreckend häufigem Rhythmus.

Jedes Mal, wenn ein Benutzer zwei E-Mails zur Anmeldung in einem Webformular verwendet, wird ein doppelter Datensatz erstellt. Jedes Mal, wenn ein Datenerfasser einen falschen oder einen neuen eindeutigen ID-Schlüssel (wie Telefonnummern oder SSNs) eingibt, wird ein doppelter Datensatz erstellt. Immer dann, wenn eine Datenquelle keine SSN verwenden darf, steigt die Wahrscheinlichkeit von Duplikaten, weil der Datenbetreiber den Feldern eigene eindeutige Schlüssel zuweisen muss, und wenn dieser Datensatz mit einem anderen Datensatz zusammengeführt werden soll, steigt die Wahrscheinlichkeit von Duplikaten. Jedes Mal, wenn ein System eine Störung aufweist, kann ein Duplikat erstellt werden. Es gibt einfach zu viele Möglichkeiten, dass Duplikate leicht erstellt werden können.

Doppelte Daten sind zeitaufwändig zu beseitigen. Die Unternehmen begehen hier einen klassischen Fehler – sie denken, dass dieses Problem einfach durch das Ausprobieren verschiedener Algorithmen gelöst werden kann, aber es ist viel komplexer. Mit herkömmlichen Methoden können Sie nur Duplikate aussortieren, die exakte Eigenschaften aufweisen. Sie können Duplikate, die scheinbar dieselben Eigenschaften haben, nicht aussondern.

Nehmen Sie zum Beispiel:

Eine Kundin, Catherine, schreibt ihren Namen an verschiedenen Stellen als Catherine Davis, Cath Davis, C. Davis. Wenn sie nun auch noch ihre Telefonnummer oder ihre E-Mail-Adresse während der Dateneingabe mehrfach geändert hat, hat das System bereits Duplikate erstellt.

Ein Algorithmus, der mit exakten Übereinstimmungen arbeitet, kann Duplikate erkennen, sofern Katharinas Name in einem anderen Datensatz auf die gleiche Weise geschrieben wird.

Wenn es jedoch andere Varianten gibt, kann es das Duplikat nicht erkennen.

Aus diesem Grund ist die Genauigkeit entscheidend, wenn es um das Entdoublieren von Daten geht.

Sie benötigen eine Lösung, die Übereinstimmungen für Millionen von Datenzeilen durchführen kann und dabei eine Kombination von Algorithmen(Fuzzy, deterministisch, Soundex usw.) verwendet, um selbst die unwahrscheinlichsten Fälle auszusortieren. In dieser Hinsicht ist die Genauigkeit der Lösung DataMatch Enterprise von Data Ladder unübertroffen.

Wie hilft die Data Ladder den Unternehmen beim Umgang mit diesen 3 Bösewichten?

In den letzten zehn Jahren hat Data Ladder Unternehmen dabei geholfen, ihre Daten sinnvoll zu nutzen. Mithilfe unserer proprietären Abgleichslösung in Kombination mit anderen Datenabgleichsalgorithmen helfen wir Unternehmen, Daten mit höchster Genauigkeit und Geschwindigkeit zu de-duphen.

Wir wissen nur zu gut, mit welchen Schwierigkeiten Unternehmen heute zu kämpfen haben. Daten sind der neue Treibstoff, aber damit diese Daten Unternehmen helfen, ihre Geschäftsziele zu erreichen, müssen sie sauber, genau und nutzbar sein. Die Unternehmen sind noch dabei, die Probleme mit ihren Daten zu verstehen – aber sie brauchen eine Lösung, die diese Probleme schnell, effizient und intelligent lösen kann.

Und so hilft die Data Ladder.

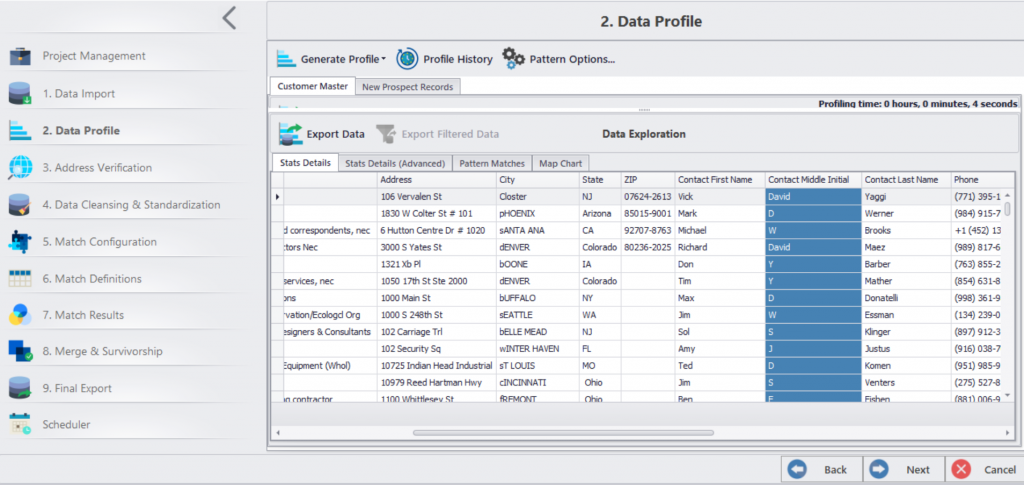

- Wir haben einen 7-stufigen Rahmen, der mit der Datenintegration beginnt und mit der Datenzusammenführung und -überlebensfähigkeit endet.

- Sie können Daten aus mehr als 150 Anwendungen auf einer Plattform integrieren.

- Nach der Integration können Sie die Daten bereinigen, standardisieren, validieren und abgleichen.

- Sie können Stammsätze anlegen und Daten zusammenführen.

- Schließlich können Sie die Datenbereinigung zu einem im Voraus festgelegten Zeitpunkt automatisieren.

Sie brauchen verlässliche Daten, um Ihre Ziele in den Bereichen Big Data-Analyse, Migration, personalisierte Kundenerfahrung und effizienter Geschäftsbetrieb schneller zu erreichen.