Dans un monde fasciné par les possibilités illimitées de l’IA, du ML et de l’analyse prédictive, la qualité des données est devenue un défi important. Les entreprises sont sur la corde raide : elles ont besoin de données précises pour créer des expériences personnalisées, mais elles n’ont pas la capacité de gérer les mauvaises données.

Les entreprises doivent faire face à deux aspects débilitants de la qualité des données, les données sales (données en double, problèmes d’orthographe, informations incomplètes, etc.) et les données non conformes. Il s’agit notamment de données qui exposent les organisations à un risque de violation du GDPR, d’analyses inexactes & de rapports erronés.

Dans cet article, nous allons nous concentrer sur :

- Comprendre les principaux enjeux de la qualité des données

- Principaux défis en matière de qualité des données que les entreprises ont du mal à relever

- Comprendre les 3D à l’aide d’une étude de cas

- Comment Data Ladder aide à surmonter ces défis

Plongeons dans le vif du sujet.

Principaux défis en matière de qualité des données que les entreprises ont du mal à relever

Les experts aiment utiliser l’expression « garbage in, garbage out » pour définir le problème de la qualité des données, mais ce n’est pas tout.

Une conclusion du rapport State of Data Quality d’OReilly indique que :

« Les organisations sont confrontées à des problèmes multiples et simultanés de qualité des données. Elles ont trop de sources de données différentes et trop de données incohérentes. Elles ne disposent pas des ressources nécessaires pour nettoyer les problèmes de qualité des données. Et ce n’est que le début. »

La bonne nouvelle ? Les hauts responsables des organisations sont conscients de cet important défi.

La mauvaise nouvelle ? Ils manquent d’outils, de ressources et de solutions pour résoudre ce problème. Beaucoup d’entre eux se débattent encore avec les processus de base de la gestion des données.

Au cours de notre expérience avec plus de 4 500 clients, y compris ceux du gouvernement et des entreprises Fortune 500, nous constatons souvent trois problèmes communs :

- Données stockées dans des sources multiples ou des systèmes disparates

- Données qui ne répondent pas aux objectifs de qualité

- L’absence d’une solution robuste de rapprochement des données permettant d’éliminer les doublons profondément enfouis.

Les entreprises ont désespérément besoin d’aide pour gérer des données disparates, sales et dupliquées.

Comprendre les 3D des données

Les données sales, disparates et dupliquées affectent les entreprises à un niveau plus profond. Ils affectent les processus organisationnels et l’efficacité opérationnelle. Ils entravent les efforts visant à instaurer une culture axée sur les données et sont la principale cause des analyses et des rapports erronés.

Données disparates :

En moyenne, une entreprise est connectée à plus de 461 applications ou systèmes. Ces systèmes collectent des données sous de multiples formats qui sont ensuite déversées dans un lac de données. Les entreprises qui ne disposent pas de lacs de données tentent d’ajouter ces données à leurs ERP, mais les difficultés liées au formatage et au mappage des données rendent ce processus fastidieux. En conséquence, les données ne sont jamais triées ou traitées jusqu’à ce qu’il y ait un besoin critique et urgent.

Prenons, par exemple, le cas de Bell Bank – une banque renommée dont la gamme de services s’étend sur les 50 États des États-Unis. Dans le cadre de sa valeur fondamentale, qui est de fournir des expériences personnalisées à ses clients, la banque a voulu mieux comprendre ses clients en évaluant leur relation et leur interaction à différents points de contact. Pour ce faire, ils devaient créer une version unique de la vérité pour chacun de leurs clients. Pour cela, elle a dû fusionner, purger, déduire et nettoyer des millions de lignes de données pour obtenir enfin une image consolidée du parcours de ses clients.

Mais qu’est-ce que des sources de données disparates ? S’agit-il simplement de données stockées dans des sources différentes ?

Eh bien non.

Les données disparates ne sont pas seulement stockées dans des sources différentes, elles ont aussi des formats de données différents, des normes variées et sont généralement considérées comme des données de faible qualité. Les données sont nettement différentes par leur nature, leur qualité ou leur caractère.

Bell Bank devra dériver des données des services de marketing, de vente, de soutien à la clientèle et de fournisseurs tiers pour obtenir une image claire du profil d’un client, de son interaction avec l’entreprise, des données sur son foyer, et bien plus encore. Toutes ces données « disparates » devront être consolidées par un processus de rapprochement des données qui donnera finalement à la banque la version de la vérité dont elle a tant besoin.

Bell Bank n’est qu’un exemple des nombreuses entreprises, banques, détaillants et institutions qui réalisent l’importance d’obtenir une vue unique du client. À une époque où les clients exigent des expériences personnalisées avant même de les demander, une vue consolidée permet aux organisations d’avoir une longueur d’avance. En comprenant le parcours de ses clients, Bell Bank sera en mesure de fournir des services personnalisés tels que des cartes de fidélité spéciales, des réductions, des avantages pour les membres, etc. Les données disjointes empêchent les entreprises d’obtenir cette vision plus approfondie, ce qui les empêche de tirer une quelconque valeur de leurs données.

Données sales

Gardez tous les problèmes liés aux sources de données disparates ci-dessus et ajoutez-y des problèmes tels que :

- Fautes d’orthographe

- Informations incomplètes (adresses sans code postal, chiffres manquants dans les numéros de téléphone, etc.)

- Utilisation de la ponctuation dans les champs de données

- Espacement négatif

- Problèmes de formatage

On pourrait penser que c’est une chose simple à gérer avec des filtres et des corrections automatiques. Mais il existe des entreprises qui ne font rien d’autre que de nettoyer les adresses physiques des rues dans les bases de données – parce que les gens utilisent des termes différents pour la rue. (par exemple, Rue, St., ST). Leurs analystes et spécialistes des données doivent passer plus de 80 % de leur temps à corriger ces données brutes – le temps et le talent qui étaient censés être consacrés à l’analyse et non à la correction d’orthographes ou d’abréviations.

Malheureusement, les données collectées via les sites web et les centres d’appels sont souvent entachées d’erreurs. Les données tirées des sites de médias sociaux sont également problématiques en termes de validité et d’exactitude. Les données collectées par l’intermédiaire de l’homme sont rarement propres. Mais demander à un analyste de données de se pencher sur des millions de lignes de données et faire de la correction des données une partie permanente de son travail n’est pas la solution.

Le nettoyage des données est un besoin constant. Cela signifie que votre entreprise a besoin d’une solution automatisée qui sera contrôlée et exploitée par un analyste de données ou un utilisateur commercial, ce qui leur laissera le temps nécessaire pour se concentrer sur l’obtention d’informations.

Données dupliquées

Il y a duplication des données lorsque la même information est collectée et stockée dans différentes sources de données sous différents formats. Et cela se produit à une fréquence alarmante.

Chaque fois qu’un utilisateur utilise deux adresses électroniques pour s’inscrire à un formulaire Web, un enregistrement en double est créé. Chaque fois qu’un opérateur de saisie de données entre une clé d’identification unique erronée ou nouvelle (comme les numéros de téléphone ou les SSN), un enregistrement en double est créé. Chaque fois qu’une source de données n’est pas autorisée à utiliser les SSN, les risques de doublons augmentent car l’opérateur de données doit attribuer ses propres clés uniques aux champs et, lorsque cet enregistrement est censé être fusionné avec un autre, les risques de doublons sont plus élevés. Chaque fois qu’un système a un problème, un duplicata peut être créé. En fait, il y a beaucoup trop de possibilités pour que des doublons soient créés facilement.

Les données dupliquées prennent beaucoup de temps à résoudre. Les entreprises commettent ici une erreur classique : elles pensent que le problème peut être résolu facilement en essayant différents algorithmes, mais c’est beaucoup plus complexe. Vous ne pouvez éliminer les doublons qui ont des propriétés exactes que par des méthodes traditionnelles. Vous ne pouvez pas éliminer les doublons qui semblent partager les mêmes propriétés.

Prenez par exemple :

Une cliente, Catherine, écrit son nom comme Catherine Davis, Cath Davis, C. Davis à différents endroits. Or, si elle a également changé de numéro de téléphone ou d’adresse électronique à plusieurs reprises au cours du processus de saisie des données, le système a déjà créé des doublons.

Un algorithme travaillant sur les correspondances exactes peut identifier les doublons à condition que le nom de Catherine soit orthographié de la même façon dans un autre enregistrement.

Mais s’il y a d’autres variations, il ne peut pas attraper le doublon.

C’est pourquoi la précision est essentielle lorsqu’il s’agit de dédupliquer des données.

Vous avez besoin d’une solution capable d’effectuer des comparaisons pour des millions de lignes de données, en utilisant une combinaison d’algorithmes(flou, déterministe, soundex, etc.) pour éliminer les cas les moins probables. À cet égard, la précision de la solution DataMatch Enterprise de Data Ladder est inégalée.

Comment Data Ladder aide-t-il les entreprises à faire face à ces 3 méchants ?

Au cours de la dernière décennie, Data Ladder a aidé les organisations à donner un sens à leurs données. Grâce à notre solution de rapprochement exclusive, combinée à d’autres algorithmes de rapprochement de données, nous aidons les entreprises à dédupliquer les données avec le plus haut niveau de précision et de rapidité.

Nous ne comprenons que trop bien les difficultés auxquelles les organisations sont confrontées aujourd’hui. Les données sont le nouveau carburant, mais pour que ces données aident les organisations à atteindre leurs objectifs commerciaux, elles doivent être propres, précises et utilisables. Les entreprises sont encore en train de comprendre les problèmes que posent leurs données, mais elles ont besoin d’une solution qui puisse résoudre ces problèmes rapidement, efficacement et intelligemment.

Et voici comment Data Ladder vous aide.

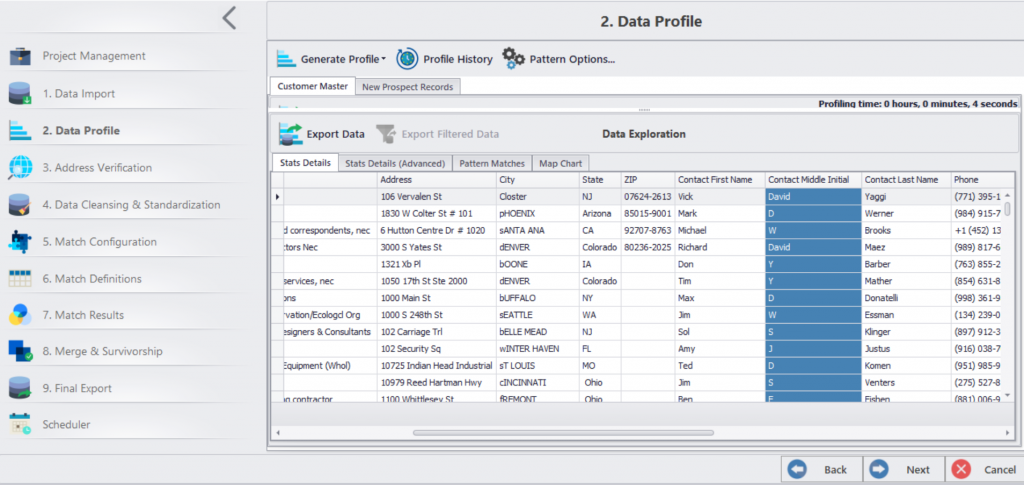

- Nous disposons d’un cadre en sept étapes, de l’intégration des données à la fusion des données et à la survie.

- Vous pouvez intégrer les données de plus de 150 applications sur une seule plateforme.

- Après l’intégration, vous pouvez nettoyer, normaliser, valider et faire correspondre les données.

- Vous pouvez créer des fiches et fusionner des données.

- Enfin, vous pouvez automatiser le nettoyage des données à une date préprogrammée.

Vous avez besoin de données fiables pour atteindre plus rapidement vos objectifs en matière d’analyse des big data, de migration, d’expérience client personnalisée et d’efficacité des opérations commerciales.