En un mundo fascinado por las oportunidades ilimitadas de la IA, el ML y el análisis predictivo, la calidad de los datos se ha convertido en un reto importante. Las empresas están al límite: necesitan datos precisos para crear experiencias personalizadas, pero no tienen la capacidad de lidiar con datos malos.

Las empresas deben hacer frente a dos aspectos debilitantes de la calidad de los datos, los datos sucios (datos duplicados, problemas de ortografía, información incompleta, etc.) y los datos no conformes. Esto incluye datos que ponen a las organizaciones en riesgo de violaciones del GDPR, análisis inexactos e informes defectuosos.

En este artículo, nos centraremos en:

- Comprender los retos críticos de la calidad de los datos

- Principales retos de la calidad de los datos que las empresas tienen que afrontar

- Comprender las 3D con un estudio de caso

- Cómo ayuda Data Ladder a superar estos retos

Vamos a sumergirnos.

Retos clave de la calidad de los datos con los que las empresas están teniendo dificultades

A los expertos les gusta utilizar la expresión «basura que entra, basura que sale» para definir el problema de la calidad de los datos.

Una de las conclusiones del informe de OReilly sobre el estado de la calidad de los datos es que:

«Las organizaciones se enfrentan a múltiples problemas simultáneos de calidad de datos. Tienen demasiadas fuentes de datos diferentes y demasiados datos incoherentes. No disponen de los recursos necesarios para solucionar los problemas de calidad de datos. Y eso es sólo el principio».

¿La buena noticia? Los altos cargos de las organizaciones son conscientes de este importante reto.

¿La mala noticia? Carecen de herramientas, recursos y soluciones para resolver este problema. Muchos siguen teniendo problemas con los procesos básicos de gestión de datos.

En nuestra experiencia con más de 4.500 clientes, incluidos los de la Administración y las empresas de la lista Fortune 500, solemos ver tres problemas comunes:

- Datos almacenados en múltiples fuentes o sistemas dispares

- Datos que no cumplen los objetivos de calidad

- La falta de una solución sólida de cotejo de datos que pueda eliminar los duplicados profundamente enterrados

Las empresas necesitan desesperadamente ayuda para manejar datos dispares, sucios y duplicados.

Entender las 3D de los datos

Los datos sucios, dispares y duplicados afectan a las empresas a un nivel más profundo. Afectan a los procesos organizativos y a la eficiencia operativa. Dificultan los esfuerzos por crear una cultura basada en los datos y son la principal causa de los análisis e informes erróneos.

Datos dispares:

De media, una empresa está conectada a más de 461 aplicaciones o sistemas. Estos sistemas recogen datos en múltiples formatos que luego se vuelcan en un lago de datos. Las empresas que no tienen lagos de datos intentan añadir estos datos a sus ERP, pero los problemas de formato y mapeo de datos hacen que este proceso sea tedioso. En consecuencia, los datos nunca se clasifican ni se tratan hasta que existe una necesidad crítica y urgente.

Tomemos, por ejemplo, el caso del Bell Bank, un banco de renombre con una línea de servicios que se extiende por los 50 estados de EE.UU. Como parte de su valor principal de proporcionar experiencias personalizadas a los clientes, el banco quería entender mejor a sus clientes evaluando su relación e interacción en varios puntos de contacto. Para ello, necesitaban crear una única versión de la verdad para cada uno de sus clientes. Para ello, tuvieron que depurar, desduplicar y limpiar millones de filas de datos para obtener finalmente una imagen consolidada del recorrido de sus clientes.

Pero, ¿qué es exactamente la disparidad de fuentes de datos? ¿Son sólo datos almacenados en diferentes fuentes?

Pues no.

Los datos dispares no sólo se almacenan en distintas fuentes, sino que también tienen formatos de datos diferentes, variedades en los estándares y suelen considerarse datos de baja calidad. Los datos son claramente diferentes en cuanto a su tipo, calidad o carácter.

Bell Bank tendrá que obtener datos de marketing, ventas, atención al cliente y terceros proveedores para tener una imagen clara del perfil de un cliente, su interacción con la empresa, los datos de su hogar y mucho más. Todos estos datos «dispares» tendrán que consolidarse a través de un proceso de cotejo de datos que finalmente dará al banco su tan necesaria versión de la verdad.

Bell Bank es sólo un ejemplo de las muchas empresas, bancos, minoristas e instituciones que se están dando cuenta de la importancia de obtener una visión singular del cliente. En una época en la que los clientes exigen experiencias personalizadas incluso antes de pedirlas, una visión consolidada ayuda a las organizaciones a ir un paso por delante. Como Bell Bank entiende el recorrido de su cliente, podrá ofrecer servicios personalizados como tarjetas especiales de fidelidad, descuentos, ventajas para los socios, etc. Los datos desarticulados impiden a las empresas obtener este conocimiento más profundo, por lo que les resulta imposible obtener ningún valor de sus datos.

Datos sucios

Mantenga todos los problemas de las fuentes de datos dispares anteriores y añada cuestiones como:

- Ortografía incorrecta

- Información incompleta (datos de dirección sin códigos postales, dígitos que faltan en los números de teléfono, etc.)

- Uso de la puntuación en los campos de datos

- Espacios negativos

- Problemas de formato

Se podría pensar que esto es algo sencillo de gestionar con filtros y autocorrecciones. Pero hay empresas que no hacen más que limpiar las direcciones físicas de las calles en las bases de datos, porque la gente utiliza términos diferentes para la calle. (por ejemplo, Street, St., ST). Sus analistas y especialistas de datos tienen que dedicar más del 80% de su tiempo a arreglar estos datos brutos, el tiempo y el talento que se suponía que era para el análisis y no para arreglar la ortografía o las abreviaturas.

Por desgracia, los datos recogidos a través de sitios web y centros de llamadas suelen estar plagados de errores. Los datos extraídos de las redes sociales también son problemáticos en términos de validez y precisión. Los datos que se recogen a través de la entrada humana casi nunca son limpios. Pero hacer que un analista de datos se siente ante millones de filas de datos y que la fijación de datos sea una parte permanente de su trabajo no es la solución.

La limpieza de datos es una necesidad constante. Esto significa que su empresa necesita una solución automatizada que sea supervisada y manejada por un analista de datos o un usuario de la empresa, dejándoles el tiempo necesario para centrarse en la obtención de información.

Datos duplicados

La duplicación de datos se produce cuando la misma información se recoge y almacena en diferentes fuentes de datos con formatos distintos. Y esto ocurre con una frecuencia alarmante.

Cada vez que un usuario utiliza dos correos electrónicos para registrarse en un formulario web, se crea un registro duplicado. Cada vez que un operador de entrada de datos introduce una clave de identificación única o incorrecta (como números de teléfono o SSN), se crea un registro duplicado. Cuando una fuente de datos no puede utilizar los SSN, las posibilidades de duplicación aumentan porque el operador de datos tiene que asignar sus propias claves únicas a los campos y cuando este registro debe fusionarse con otro, se produce una mayor probabilidad de duplicación. Cada vez que un sistema tiene un fallo, se puede crear un duplicado. De hecho, hay demasiadas posibilidades de que se creen duplicados con facilidad.

La duplicación de datos es una tarea que lleva mucho tiempo. Las empresas cometen un error clásico aquí: creen que esto se puede resolver fácilmente probando diferentes algoritmos, pero es mucho más complejo. Sólo se pueden eliminar los duplicados que tienen propiedades exactas mediante los métodos tradicionales. No puede eliminar los duplicados que aparentemente comparten las mismas propiedades.

Por ejemplo:

Un cliente, Catherine, escribe su nombre como Catherine Davis, Cath Davis, C. Davis en diferentes lugares. Ahora bien, si además ha cambiado su número de teléfono o su dirección de correo electrónico en varias ocasiones durante el proceso de introducción de datos, el sistema ya ha creado duplicados.

Un algoritmo que trabaja con coincidencias exactas puede identificar los duplicados siempre que el nombre de Catherine se escriba igual en otro registro.

Pero si hay otras variaciones, no puede atrapar el duplicado.

Por eso, la precisión es fundamental a la hora de desduplicar los datos.

Se necesita una solución que pueda ejecutar coincidencias para millones de filas de datos, utilizando una combinación de algoritmos(difusos, deterministas, soundex, etc.) para eliminar incluso los casos menos probables. En este sentido, la precisión de la solución DataMatch Enterprise de Data Ladder no tiene rival.

¿Cómo ayuda Data Ladder a las empresas a manejar estos 3 tipos malos?

Durante la última década, Data Ladder ha ayudado a las organizaciones a dar sentido a sus datos. Gracias a nuestra solución de concordancia patentada, en combinación con otros algoritmos de concordancia de datos, ayudamos a las empresas a desduplicar los datos con el máximo nivel de precisión y rapidez.

Comprendemos muy bien las dificultades a las que se enfrentan las organizaciones hoy en día. Los datos son el nuevo combustible, pero para que esos datos ayuden a las organizaciones a cumplir sus objetivos empresariales, deben ser limpios, precisos y utilizables. Las empresas siguen avanzando a medida que empiezan a comprender los problemas que plantean sus datos, pero necesitan una solución que pueda resolver estos problemas de forma rápida, eficaz e inteligente.

Y así es como ayuda Data Ladder.

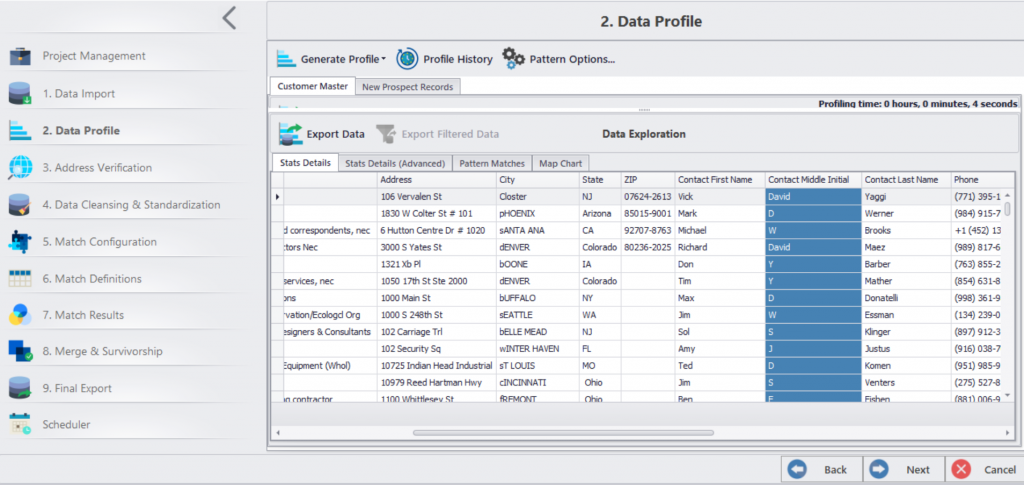

- Contamos con un marco de 7 etapas que comienza con la integración de datos y termina con la fusión de datos y la supervivencia.

- Puede integrar datos de más de 150 aplicaciones en una sola plataforma.

- Tras la integración, puede limpiar, normalizar, validar y hacer coincidir los datos.

- Puede crear registros maestros y fusionar datos.

- Por último, puede automatizar la limpieza de datos en una fecha programada.

Necesita datos de confianza para alcanzar antes sus objetivos de análisis de big data, migración, experiencia personalizada del cliente y funcionamiento eficiente del negocio.