Bei einer Umfrage unter 1900 Datenteams nannten mehr als 60 % zu viele Datenquellen und inkonsistente Daten als größte Herausforderung für die Datenqualität. Doch wenn es darum geht, die Datenqualität zu verbessern, befinden sich Datenverantwortliche oft in einer schwierigen Lage, da wichtige Entscheidungen getroffen werden müssen. Eine der wichtigsten Entscheidungen, die es zu treffen gilt, lautet: An welchem Punkt des Datenlebenszyklus sollten wir die Datenqualität prüfen und verbessern?

Um diese Frage zu beantworten, müssen einige Aspekte berücksichtigt werden. Da viele Unternehmen regelmäßig riesige Datenmengen produzieren und diese durchgängig im gesamten Unternehmen verwenden, ist ein reaktiver Ansatz – bei dem die Daten nach der Speicherung bereinigt werden – möglicherweise nicht die beste Wahl, da er die Zuverlässigkeit und Verfügbarkeit der Daten beeinträchtigt. Der Einsatz einer zentralen Datenqualitäts-Firewall, bei der die Daten vor der Speicherung in der Datenbank geprüft und behandelt werden, könnte in solchen Fällen die bessere Option sein.

Wenn Sie mehr über die Unterschiede zwischen den beiden Ansätzen erfahren möchten, lesen Sie unseren letzten Blog: Batch-Verarbeitung versus Echtzeit-Validierung der Datenqualität.

Bei den meisten reaktiven Ansätzen verwenden die Datenverantwortlichen oder andere Mitglieder des Datenqualitätsteams eine Software-Schnittstelle, um die Datenqualität zu testen und zu verbessern. Bei einem proaktiven Ansatz wird diese Aufgabe jedoch in der Regel über eine API abgewickelt. In diesem Blog werden wir uns mit verschiedenen Aspekten befassen, die bei der Bereitstellung einer Datenqualitäts-Firewall mit solchen APIs zu berücksichtigen sind. Fangen wir an.

Was ist eine Datenqualitäts-API?

Eine API (Application Programming Interface) ist eine Software-Schnittstelle, die es Anwendungen ermöglicht, miteinander zu kommunizieren. Eine API befindet sich zwischen zwei Softwareanwendungen und verarbeitet die übertragenen Anfragen/Antworten. Wenn Sie zwei Systeme integrieren oder verbinden wollen, tun Sie dies normalerweise mit Hilfe einer API.

In ähnlicher Weise bedeutet eine Datenqualitäts-API:

Ein Software-Vermittler, der Anfragen/Antworten für verschiedene Datenqualitätsfunktionen bereitstellt.

Architektonische Umsetzung einer Datenqualitäts-API

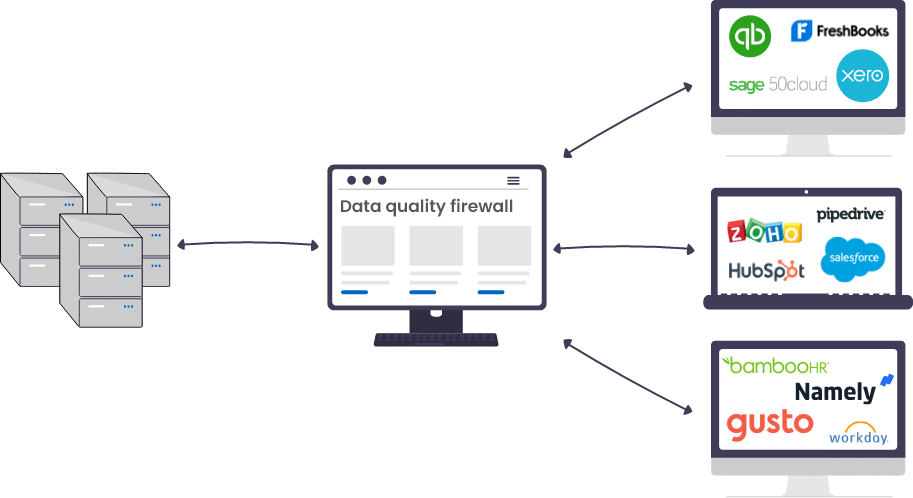

Eine Datenqualitäts-API wird oft unter verschiedenen Bezeichnungen geführt. Zum Beispiel Datenqualitäts-Firewall, Datenqualitätsvalidierung in Echtzeit, zentrale Datenqualitäts-Engine, usw. Solche Namen werden vergeben, da die API zwischen der Anwendung, die die Daten erfasst, und der Datenbank, die sie speichert, fungiert.

Datenqualitäts-APIs basieren (wie alle anderen APIs auch) auf einer ereignisgesteuerten Architektur. Sie werden ausgelöst, wenn ein Ereignis eintritt. Wenn also neue Daten durch eine verbundene Anwendung kommen oder vorhandene Daten aktualisiert werden, werden sie zunächst durch die API geleitet (wo die Datenqualität überprüft wird) und dann an die Quelldatenbank weitergeleitet. Dadurch fungiert die API als Gateway zwischen einer Datenerfassungsanwendung und einer Datenspeicherquelle, wodurch sichergestellt wird, dass keine Datenqualitätsfehler von der ersten Seite auf die zweite Seite übertragen werden.

Beispiel für die Validierung der Datenqualität in Echtzeit für Kundendaten

Wenn Sie eine zentrale Datenqualitäts-Firewall einsetzen, werden die eingehenden Daten nahezu in Echtzeit auf ihre Qualität geprüft. Wenn beispielsweise eine Änderung an einem Kundendatensatz vorgenommen oder ein neuer Kundendatensatz in einer angeschlossenen Anwendung erstellt wird, wird die Aktualisierung zunächst an die zentrale Datenqualitäts-Engine gesendet. Hier wird die Änderung anhand der konfigurierten Datenqualitätsdefinition überprüft, z. B. um sicherzustellen, dass die erforderlichen Felder nicht leer sind, dass die Werte dem Standardformat und -muster entsprechen, dass ein neuer Kundendatensatz möglicherweise nicht mit einem bestehenden Kundendatensatz übereinstimmt usw.

Wenn Datenqualitätsfehler gefunden werden, wird eine Liste von Transformationsregeln ausgeführt, um die Daten zu bereinigen. In manchen Fällen benötigen Sie einen Datenqualitätsbeauftragten, der eingreift und Entscheidungen trifft, wenn Datenwerte mehrdeutig sind und von konfigurierten Algorithmen nicht gut verarbeitet werden können. So besteht beispielsweise eine 60-prozentige Wahrscheinlichkeit, dass es sich bei einem neuen Kundendatensatz um ein Duplikat handelt, und jemand muss das Problem manuell überprüfen und beheben. Anschließend wird der bereinigte, abgeglichene und überprüfte Datensatz an eine Zielquelle gesendet, bei der es sich um einen Stammdatensatz, ein Data Warehouse, ein Business Intelligence-System usw. handeln kann.

Ein Beispiel für eine solche Architektur ist nachstehend schematisch dargestellt:

Funktionen einer Datenqualitäts-API

Eine gute Datenqualitäts-API ist in der Lage, verschiedene Arten von Datenqualitätsfunktionen für eingehende Daten auszuführen. Je nach den Prozessen, die in Ihrem Datenqualitätsrahmenwerk enthalten sind, können Sie die erforderlichen Funktionen über die API abonnieren. Da es sich die meisten Unternehmen jedoch nicht leisten können, wiederkehrende oder neue Datenqualitätsprobleme durch das System fallen zu lassen, abonnieren sie meist so viele Datenqualitätsvalidierungs- und -behebungstechniken, wie die API bietet.

Zu den häufigsten Funktionen, die von einer Datenqualitäts-API angeboten werden, gehören:

1. Verbindung zu Datenquellen

Dies ist die wichtigste und nützlichste Funktion, die eine Datenqualitäts-API bietet. Unternehmen verwenden mehrere datenerzeugende Anwendungen, z. B. Website-Tracking-Tools, Marketing-Automatisierungstools, CRMs usw. Aus diesem Grund muss eine Datenqualitäts-API in der Lage sein, eine Verbindung zu diesen verschiedenen Anwendungen herzustellen und mit ihnen zu kommunizieren, ebenso wie mit der Zieldatenbank, in der die eingehenden Daten normalerweise landen.

2. Datenqualitätsprüfungen durchführen

Immer wenn in einer angeschlossenen Anwendung ein Ereignis eintritt (ein neuer Datensatz wird erstellt oder ein bestehender aktualisiert), kann die API die eingehenden Daten auf Datenqualitätsfehler prüfen und ein Profil erstellen. Dies geschieht durch die Ausführung statistischer Algorithmen, die die eingehenden Daten bewerten und überprüfen, ob sie der Definition der Datenqualität entsprechen. Diese Kontrollen umfassen die Sicherstellung, dass:

- Erforderliche Felder werden nicht leer gelassen,

- Die Felder entsprechen dem korrekten Datentyp, Muster und Format und liegen innerhalb des gültigen Bereichs,

- Ein neuer Datensatz ist eindeutig und kein Duplikat eines bestehenden Datensatzes,

- Die neuen Daten werden anhand benutzerdefinierter Geschäftsregeln validiert.

3. Behebung von Datenqualitätsproblemen

Eine Datenqualitäts-API bietet eine Reihe von Funktionen, mit denen die bei der Datenprofilierung entdeckten Fehler und Probleme behoben werden können. Zu diesen Funktionen gehören unter anderem:

- Parsing von aggregierten Feldern in Teilkomponenten zur Erstellung aussagekräftigerer Feldwerte,

- Umwandlung von Datentypen, -mustern und -formaten nach Bedarf,

- Entfernen von unnötigen Leerzeichen, Zeichen oder Wörtern,

- Umwandlung von Abkürzungen in richtige Wörter,

- Überschreiben oder Zusammenführen eines neuen Datensatzes mit dem doppelten Datensatz (falls bereits ein Datensatz für dieselbe Entität existiert).

4. Warnungen zur manuellen Überprüfung auslösen

Manchmal ist eine Datenqualitäts-API nicht in der Lage, bestimmte Datenqualitätsprobleme zu beheben, die von Natur aus komplex sind. In solchen Fällen werden Warnungen an die entsprechenden Beteiligten (Datenverwalter oder Datenanalysten) ausgegeben, damit die Fehler manuell überprüft und eine der vorgeschlagenen Maßnahmen ergriffen werden kann. Bei einem neuen Datensatz wird beispielsweise vermutet, dass es sich um eine Dublette mit einer Wahrscheinlichkeitsquote von 65 % handelt. Solche mehrdeutigen Situationen erfordern menschliches Eingreifen, um das Problem zu lösen und die richtige Entscheidung zu treffen.

5. Daten zur Zielquelle verschieben

Sobald die Daten gemäß dem erforderlichen Datenqualitätsstandard validiert sind, besteht die letzte Funktion der API darin, sie an die Zielquelle zu übertragen. Manchmal handelt es sich dabei um eine einzige Datenbank, in anderen Fällen kann es mehrere Ausgabestellen geben, z. B. ein Business-Intelligence-System, ein Data-Warehouse oder andere Anwendungen von Dritten usw.

Vorteile einer Datenqualitäts-API

Hier sind einige Vorteile einer zentralen Datenqualitäts-Firewall:

1. Maximierung der Zuverlässigkeit und Verfügbarkeit der Daten

Laut dem Rethink Data Report 2020 von Seagate werden nur 32 % der Unternehmensdaten genutzt, während die restlichen 68 % aufgrund von Nichtverfügbarkeit und Unzuverlässigkeit der Daten verloren gehen.

Einer der größten Vorteile der Datenqualitätsprüfung in Echtzeit besteht darin, dass sie einen zuverlässigen Datenzustand zu den meisten Zeiten gewährleistet, indem sie die Datenqualität sofort nach jeder Aktualisierung validiert und korrigiert. Da eine Datenqualitäts-API die Daten verarbeitet, bereinigt und standardisiert, sobald sie in das System gelangen, sind sie mit größerer Wahrscheinlichkeit verfügbar, wenn ein Verbraucher die Daten abfragt, um Routineaufgaben durchzuführen.

2. Verbesserung der geschäftlichen und betrieblichen Effizienz

Eine kürzlich durchgeführte Umfrage zeigt, dass 24 % der Datenteams Tools verwenden, um Datenqualitätsprobleme zu finden, die jedoch in der Regel nicht behoben werden.

Die meisten Datenqualitätstools sind in der Lage, Probleme zu erkennen und Warnungen auszulösen, wenn die Datenqualität unter einen akzeptablen Schwellenwert sinkt. Sie lassen jedoch einen wichtigen Aspekt außer Acht: die Automatisierung der Ausführung von Datenqualitätsprozessen (zeit- oder ereignisbasiert) und die automatische Lösung von Problemen. Das Fehlen einer solchen Strategie zwingt zu menschlichen Eingriffen – das heißt, jemand muss Datenqualitätsprozesse im Tool auslösen, überwachen und beenden, um diese Probleme zu beheben.

Dies ist ein großer Mehraufwand, den eine Firewall für Datenqualität leicht beheben kann. Unternehmen möchten in eine zentrale Datenqualitäts-Engine investieren, die in der Lage ist, fortschrittliche Datenqualitätstechniken mit minimalem menschlichem Eingriff auszuführen. Dies wirkt sich positiv auf die betriebliche Effizienz des Unternehmens und die Produktivität der Teams aus.

3. Individuelle Lösungen entwickeln

Heutzutage wird die Definition von Qualitätsdaten von der jeweiligen Organisation kontrolliert und hängt von speziellen Geschäftsregeln ab. Datenvalidierungstechniken, die in Dateneingabeformularen implementiert oder durch ein jahrelanges Python-Skript ausgeführt werden, reichen nicht aus. Unternehmen suchen jetzt nach einer eigenen, maßgeschneiderten Datenqualitäts-Engine, die auf ihre spezifischen Anforderungen zugeschnitten ist. Hier bietet eine Datenqualitäts-API enorme Vorteile, unabhängig davon, ob Sie Ihr eigenes Datenqualitäts-Framework, Ihre eigene Datenmanagement-Architektur oder benutzerdefinierte Datenlösungen entwickeln möchten.

4. Mehr Kontrolle über die Validierung der Datenqualität

Das Beste an einer API ist die Möglichkeit der Personalisierung oder Anpassung, die sie bietet. Auf diese Weise haben Sie mehr Kontrolle darüber, wie Ihre Prozesse funktionieren und welchen Output sie erzeugen. So können Sie beispielsweise benutzerdefinierte Geschäftsregeln für die Datenqualitätsprüfung definieren sowie Schwellenwerte und Variablen konfigurieren, die für Ihre Unternehmensdaten geeignet sind.

Ein weiteres Beispiel hierfür ist die Integration eines maßgeschneiderten Portals zur Verfolgung von Problemen in das System, das Warnmeldungen an die Datenverwalter sendet, wenn etwas sofortige Aufmerksamkeit erfordert. Datenverantwortliche können das Portal nutzen, um manuelle Überprüfungen vorzunehmen und Entscheidungen bei Bedarf außer Kraft zu setzen.

5. Umsetzung wirksamer Data-Governance-Richtlinien

Ein weiterer Vorteil des Einsatzes einer zentralen Datenqualitäts-Firewall besteht darin, dass sie eine wirksame Umsetzung der Data-Governance-Richtlinien gewährleistet. Der Begriff Data Governance bezieht sich in der Regel auf eine Sammlung von Rollen, Richtlinien, Arbeitsabläufen, Standards und Metriken, die eine effiziente Informationsnutzung und -sicherheit gewährleisten und es einem Unternehmen ermöglichen, seine Geschäftsziele zu erreichen.

Die benutzerdefinierte Implementierung einer Datenqualitätslösung unter Verwendung einer API kann dabei helfen, die erforderlichen Datenrollen und Berechtigungen zu erstellen, Workflows zur Überprüfung von Informationsaktualisierungen zu entwerfen, mehrere Datenbestände zusammenzuführen, zu verfolgen, wer wann Informationen aktualisiert hat usw.

6. Datenquellen für die intelligente Suche

Da eine Datenqualitäts-Firewall mit allen wichtigen Datenquellen eines Unternehmens verbunden ist, bietet diese Architektur versteckte Vorteile, und einer davon ist die intelligente Suche nach Daten in allen Quellen. Dies ist von Vorteil, wenn Unternehmen Daten aus einer oder mehreren Datenbanken auf intelligente Weise abfragen wollen, ohne fortgeschrittene SQL-Skripte oder Programmiersprachen zu verwenden. Eine Firewall für die Datenqualität kann dabei helfen, da sie komplexe und fortschrittliche Algorithmen für den Datenabgleich enthält.

Wenn Sie beispielsweise verbundene Quellen nach Datensätzen mit dem Vornamen Elizabeth durchsuchen, führt die API logische Geschäftsregeln aus, um Daten abzufragen und abzugleichen – einschließlich unscharfer, phonetischer und domänenspezifischer Datenabgleichstechniken. Dies bietet intelligente Ergebnisse in Echtzeit, bei denen die Datensätze mit einer möglichen Variante des Wortes Elizabeth als Vorname ebenfalls abgerufen und angezeigt werden, wie z. B. Elisabeth, Alizabeth, Lisa, Beth, usw.

7. Weniger Aufwand für Import/Reimport/Export

Ein weiterer Vorteil des Einsatzes einer Datenqualitäts-API besteht darin, dass sich der Aufwand für das Exportieren, Importieren und Reimportieren von Daten verringert. Dies muss mit einem eigenständigen Datenqualitätswerkzeug geschehen, um Datensätze zu bereinigen, abzugleichen und zu überprüfen. Mit einer API können Sie die gesamte Bereinigung, den Abgleich und die Adressüberprüfung vornehmen, ohne Ihr Quellsystem zu verlassen. Damit kann Ihr Datenqualitätswerkzeug direkt mit mehreren Datenquellen kommunizieren, um alle zugehörigen Datensätze zu finden. Es kann auch automatisch Änderungen an den Daten vornehmen, was Ihnen Zeit und Geld spart und die Gefahr von Fehlern verringert.

8. Automatisches Anhängen an Data Warehouses

Unternehmen speichern und pflegen tonnenweise historische Datensätze über Kunden, Produkte und Lieferanten in Data Warehouses. Millionen solcher Datensätze werden täglich oder wöchentlich erstellt. Bevor jedoch neue Datensätze in das Core Data Warehouse verschoben werden können, müssen diese auf entsprechende Datenqualitätsstandards getestet und bei Dubletten abgeglichen werden, um sicherzustellen, dass der kommende Datensatz den alten bereichert und nicht erneut erstellt wird als neuer Rekord.

Hier leistet eine Datenqualitäts-API Außerordentliches: Sie verarbeitet große Datenmengen nahezu in Echtzeit im Hintergrund, ermittelt die eindeutige ID eines vorhandenen Datensatzes, führt einen Datenabgleich durch, um exakte oder unscharfe Übereinstimmungen zu ermitteln, und fügt neue Datenattribute an den vorhandenen Datensatz an.

Schlussfolgerung

Die Implementierung konsistenter, automatisierter und wiederholbarer Datenqualitätsmaßnahmen kann Ihrem Unternehmen helfen, die Datenqualität in allen Datensätzen in Echtzeit zu erreichen und zu erhalten.

Data Ladder hat gedient Datenqualitätslösungen für seine Kunden seit über einem Jahrzehnt. DataMatch Enterprise ist eines der führenden Datenqualitätsprodukte des Unternehmens – sowohl als eigenständige Anwendung als auch als integrierbares API – damit können Sie jede beliebige Datenqualitätsmanagementfunktion in Ihrer benutzerdefinierten oder bestehenden Anwendung verwenden und für Echtzeit einrichten Verbindung zur Datenquelle, Profilierung, Säuberung, passend, Deduplizierung, und merge purge.

Laden Sie noch heute die kostenlose Testversion herunter oder vereinbaren Sie einen persönlichen Termin mit unseren Experten, um zu erfahren, wie Sie mit Hilfe der API-Funktionen von DME Ihre eigene maßgeschneiderte Lösung erstellen und das Beste aus Ihren Daten herausholen können.