Last Updated on décembre 21, 2021

En mars 2017, le Rescue 116 s’est écrasé contre un obstacle de 282 pieds – l’île Blackrock au large de la côte du comté de Mayo. Des enquêtes plus approfondies ont révélé que l’exploitant de l’hélicoptère du CHC Ireland n’avait pas mis en place un système « formalisé, normalisé, contrôlé ou périodique ». De ce fait, la base de données utilisée par l’opérateur pour examiner les itinéraires de vol ne contenait pas de détails sur l’île de Blackrock. Il a été rapporté que l’équipage n’a été averti de cet obstacle sur sa route de vol qu’à 13 secondes de celui-ci. Le pire est qu’une plainte a été déposée au sujet de cette inexactitude de la base de données des garde-côtes irlandais 4 ans avant l’incident, mais aucune mesure corrective n’a été prise.

Dans un monde où chaque action est guidée par les données (que ce fait soit officiellement reconnu ou non), ces incidents prouvent que le coût d’une mauvaise qualité des données est fortement sous-estimé. Mais le plus grand défi rencontré lors de l’évaluation de la qualité des données est le manque de mesures rapides et opportunes qui peuvent alerter les parties prenantes lorsque la qualité de leurs données passe en dessous d’un seuil acceptable.

Dix dimensions de l’évaluation de la qualité des données

En d’autres termes, la qualité des données est assurée lorsque les données peuvent être utilisées pour l’objectif prévu sans rencontrer d’erreurs. La qualité des données est généralement mesurée à l’aide de ces dix dimensions critiques :

Mais on se demande souvent avec quelle rapidité ces dimensions peuvent être mesurées – et à quel niveau – afin que les équipes puissent être alertées à temps de la détérioration de la qualité des données et de son impact sur les coûts d’exploitation des données.

Mesure du vendredi après-midi (FAM) – Évaluation rapide de la qualité des données

Tom Redman a proposé la méthode de mesure du vendredi après-midi (FAM) qui répond rapidement et puissamment à la question : Dois-je me préoccuper de la qualité des données ?

Cette méthode fournit une méthode de calcul rapide et efficace qui peut être réalisée en une heure environ un vendredi après-midi, lorsque le rythme de travail a ralenti – d’où son nom. Cette méthode permet d’évaluer la qualité des données sur une base hebdomadaire, de sorte que les signaux d’alarme peuvent être levés avant que la situation ne devienne incontrôlable. Selon le FAM, la qualité des données peut être mesurée comme suit :

Étape 1 : Rassembler les données récentes

Commencez par rassembler des échantillons de données provenant des activités les plus récentes liées aux données qui ont eu lieu dans votre service. Par exemple, pour le département des ventes, il peut s’agir des 100 dernières entrées d’enregistrement dans votre CRM. Ici, vous pouvez utiliser les données qui ont été récemment créées ou récemment utilisées. Une fois que vous avez ces 100 enregistrements, sélectionnez 10 à 15 éléments de données ou attributs – en fait, les informations les plus importantes concernant ces enregistrements.

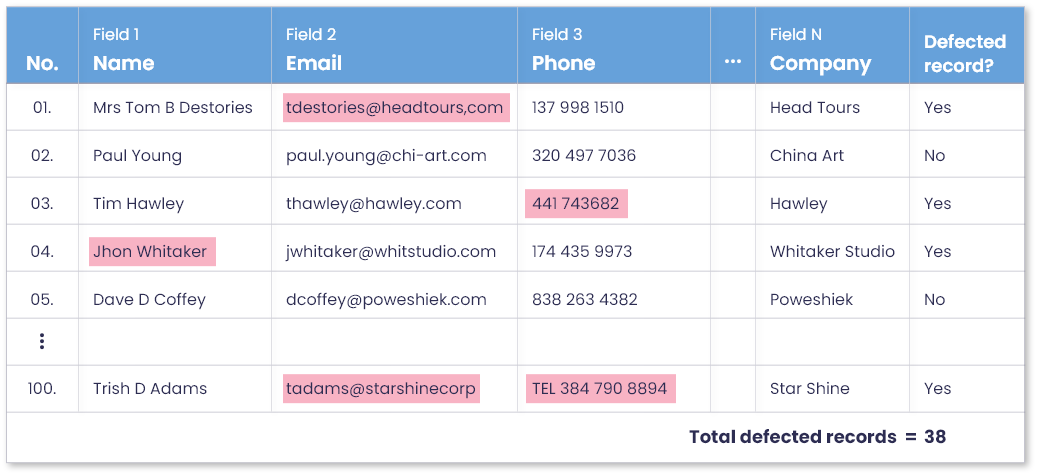

Étape 2 : Marquer les enregistrements défectueux et les enregistrements sans défaut

Invitez quelques personnes de votre équipe qui ont des connaissances sur les données considérées et demandez-leur de participer à une réunion de deux heures avec vous. Passez en revue les enregistrements sélectionnés et leurs attributs, et marquez toutes les valeurs pour lesquelles vous rencontrez une erreur de qualité des données (c’est-à-dire que la valeur est nulle, invalide, mal orthographiée, etc.)

Cette activité ne prend généralement pas beaucoup de temps, car les erreurs de qualité des données sont généralement évidentes. Mais il peut y avoir un petit nombre d’enregistrements qui nécessitent des discussions plus approfondies entre les membres de l’équipe pour analyser les problèmes de qualité des données.

Lorsque vous avez marqué ces divergences dans tous les enregistrements, vous êtes maintenant prêt à ajouter une nouvelle colonne dans l’ensemble de données de l’échantillon intitulée « Enregistrement parfait ? », et à remplir les valeurs de la colonne selon qu’une erreur a été rencontrée pour un enregistrement ou non. À la fin, vous pouvez ajouter et calculer le nombre d’enregistrements défectueux et sans défaut marqués dans l’ensemble de données d’échantillon.

Étape 3 : Mesurer la qualité des données en pourcentage

Il est maintenant temps de mettre les choses en perspective et d’obtenir des résultats concluants. Disons que, sur les 100 derniers enregistrements créés ou utilisés par votre équipe, seuls 62 se sont avérés totalement parfaits, tandis que les 38 autres comportaient une ou plusieurs erreurs de qualité des données. Un taux d’erreur de 38 % dans un ensemble de données récemment collectées/utilisées déclenche un signal d’alarme et confirme que votre service a un problème de qualité des données.

Étape 4 : Calculer le coût d’une mauvaise qualité des données en appliquant la règle des dix (RdT)

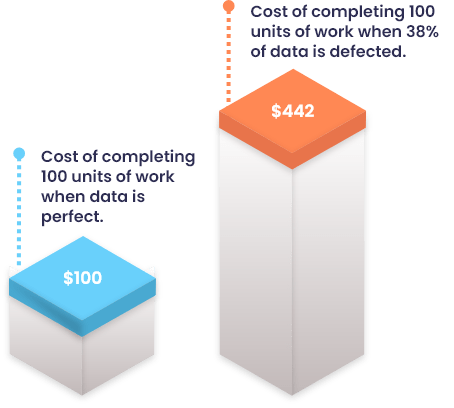

La méthode ne s’arrête pas là. Il va plus loin en calculant le coût estimé d’une mauvaise qualité des données, afin que votre équipe – et les cadres dirigeants – puissent comprendre l’impact des mauvaises données. Ce calcul des coûts tient compte de la règle des dix : Il coûte dix fois plus cher de réaliser une unité de travail lorsque les données sont défectueuses que lorsqu’elles sont parfaites.

Ainsi, par exemple, si le coût d’une seule unité de travail est de 1 $ lorsque les données sont parfaites, le coût total peut être calculé comme suit :

Coût total = (62$1) + (38$1*10) = 62$ + 380$ = 442$.

Cela montre que les enregistrements de données défectueux vous coûtent environ quatre fois plus cher que si les données étaient parfaites. Maintenant que vous savez que vous avez un problème de qualité des données et que vous connaissez le coût de son impact, vous pouvez maintenant prendre des mesures correctives pour corriger ces erreurs.

Mise en œuvre de FAM avec DataMatch Enterprise – Le meilleur logiciel de qualité des données de sa catégorie

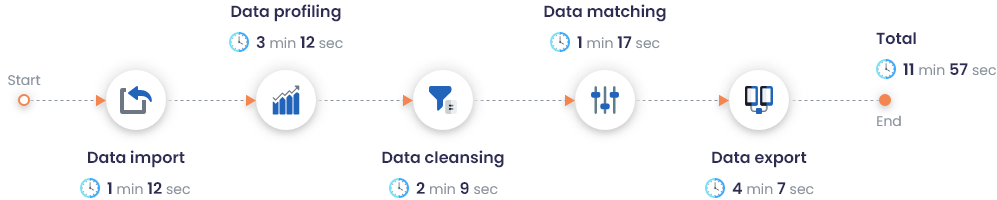

La méthode FAM s’est avérée être une méthode très efficace en termes de coûts et de temps, puisqu’elle donne des résultats en une réunion de 2 heures entre deux à trois membres de l’équipe. Pourtant, ce temps peut être réduit à seulement 3-5 minutes, impliquant un seul membre de l’équipe, en utilisant un outil logiciel de qualité des données en libre-service.

DataMatch Enterprise (DME ) est un outil complet de gestion de la qualité des données qui utilise une variété d’algorithmes statistiques pour profiler, nettoyer, faire correspondre et déduire vos données. Il est doté de capacités de profilage étendues qui créent un rapport instantané à 360° de la qualité de vos données en identifiant les valeurs vides, les formats et types de données incorrects, les modèles invalides et d’autres statistiques descriptives.

Étiquetage automatique des enregistrements parfaits et imparfaits en quelques secondes

Au lieu d’identifier et de marquer manuellement les divergences présentes dans votre ensemble de données, votre équipe peut, à elle seule, générer un rapport qui étiquette et numérote les enregistrements parfaits et imparfaits en quelques secondes seulement, même avec un échantillon de 2 millions d’enregistrements.

Les performances de DataMatch Enterprise sur un jeu de données contenant 2M d’enregistrements ont été enregistrées comme suit :

Génération et filtrage de profils détaillés de qualité des données

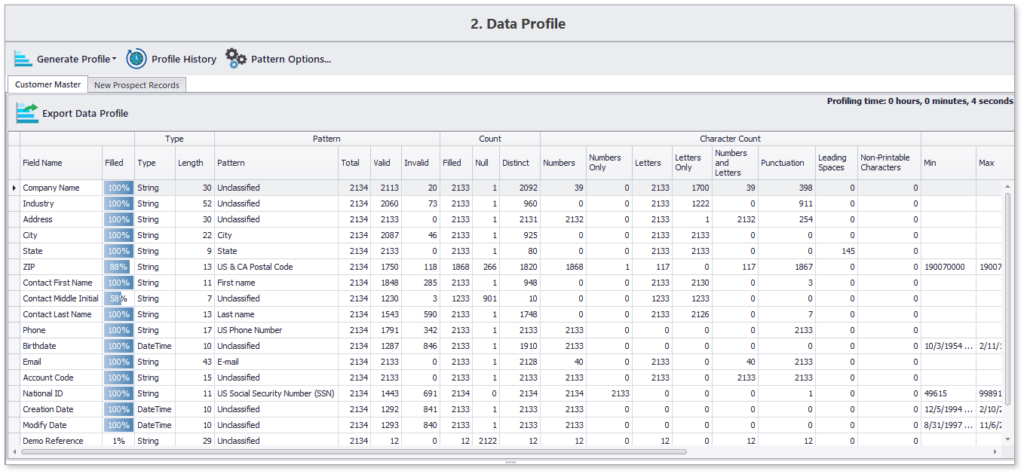

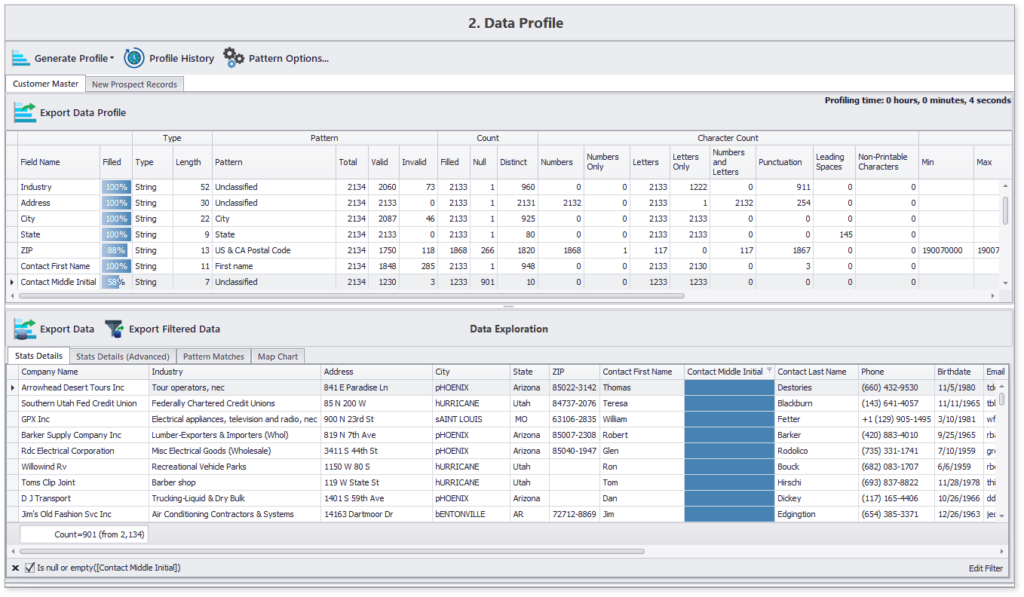

Voici un exemple de profil généré à l’aide de DME en moins de 10 secondes pour environ 2000 enregistrements :

Ce profil de données concis met en évidence les détails du contenu et de la structure de tous les attributs de données choisis. En outre, vous pouvez également naviguer vers des éléments spécifiques, tels que la liste des 12% d’enregistrements auxquels il manque le deuxième prénom du contact.

Prochaine étape – De l’évaluation de la qualité des données à la fixation de la qualité des données

Les caractéristiques et les capacités de DME ne s’arrêtent pas à l’évaluation de la qualité des données ; il est plutôt conçu pour utiliser les résultats de l’évaluation afin de résoudre les problèmes de qualité des données :

- Exécution de diverses techniques de nettoyage et de normalisation des données pour corriger les valeurs incomplètes, invalides ou mal formatées.

- Exécution d’algorithmes de correspondance des données qui identifient les doublons à l’aide de techniques de correspondance exacte et floue.

- Configuration des règles pour sélectionner l’enregistrement unique dans le groupe de doublons identifiés.

- Écraser les valeurs des colonnes pour atteindre une source unique de vérité

De plus, DME s’intègre à pratiquement n’importe quelle source et extrait des enregistrements de données remontant à la date spécifiée, tout en renvoyant des résultats propres et normalisés à la source. Toutes ces fonctionnalités sont réunies dans un logiciel unique de qualité des données, conçu pour être utilisé dans n’importe quel département de n’importe quelle industrie.

Pour en savoir plus sur la façon dont notre solution peut vous aider à mettre en œuvre la méthode FAM sur votre ensemble de données, ou à résoudre vos problèmes de qualité de données, inscrivez-vous à un essai gratuit dès aujourd’hui ou organisez une démonstration avec l’un de nos professionnels expérimentés.